疯狂的GPTBot:当AI爬虫变成‘数据吸血鬼’,小公司如何自保?

最近,一家小型初创公司 Triplegangers 遭遇了一场意外的“灾难”:他们的网站突遭瘫痪,服务器不堪重负,而这一切的幕后黑手,竟然是 OpenAI 的爬虫工具——GPTBot。

最近,一家小型初创公司 Triplegangers 遭遇了一场意外的“灾难”:他们的网站突遭瘫痪,服务器不堪重负,而这一切的幕后黑手,竟然是 OpenAI 的爬虫工具——GPTBot。

万万没想到!一家小公司网站被“搞崩”,罪魁祸首竟是OpenAI的爬虫工具——GPTBot

这起事件不仅引发了技术圈的广泛讨论,也让人们重新审视了 AI 公司在抓取互联网数据时可能引发的风险和争议。

(GPTBot是OpenAI早年前推出的一款工具,用来自动抓取整个互联网的数据。)

“疯狂的爬虫”如何让小公司网站宕机?

事件的起因看似简单,但背后却暴露了大模型公司对高质量数据的“饥渴”。作为一个只有 7 人团队的小型初创公司,Triplegangers 的网站承载着他们十多年的心血,主要提供高质量的 人类数字孪生数据库。网站内容包括由真人扫描生成的 3D 图像,以及覆盖种族、年龄、体型、纹身、疤痕等细致标签的数据,为 3D 艺术家、游戏设计师等用户群体提供服务。

然而,几天前,团队突然发现,网站的访问速度急剧下降,页面无法正常加载。CEO 和团队连夜检查服务器日志,最终锁定了“罪魁祸首”——OpenAI 的 GPTBot。

疯狂的爬虫行为

根据团队分析,GPTBot 的爬取行为堪称“狂野”:

网站上有超过 65000 种产品,每种产品都有独立页面,每个页面包含至少 3 张图片。

OpenAI 的爬虫试图抓取包括数十万张图片在内的所有数据,同时还试图获取详细的描述内容。

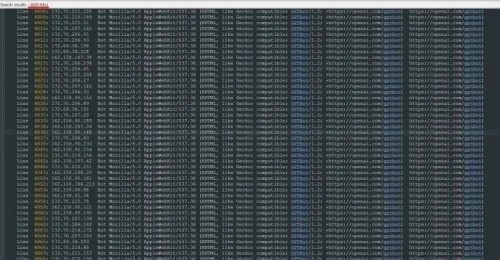

一周之内,他们的日志显示,GPTBot 使用了 超过 600 个 IP 地址 发起了 数以万计的请求。

△Triplegangers服务器日志:OpenAI机器人未经许可疯狂爬虫

这一系列行为直接导致了服务器资源的过度消耗,使网站不堪重负而宕机。CEO 直言,这简直就是一次未经授权的 DDoS 攻击。

宕机背后,资源开销剧增

宕机带来的影响并不仅仅是用户无法访问网站那么简单,更严重的是对公司成本的冲击。由于爬虫行为引发了超负荷的 CPU 使用以及大量的数据传输,Triplegangers 在 AWS 上的云资源费用暴涨。这对于一家小型初创团队来说,无疑是巨大的经济负担。

CEO 表示:“我们不仅为 OpenAI 的爬虫行为付出了网站瘫痪的代价,更不得不承担巨额的服务器成本。更令人懊恼的是,我们甚至不知道 OpenAI 爬取了哪些数据,根本联系不上对方,也无法获取任何解释或补偿。”

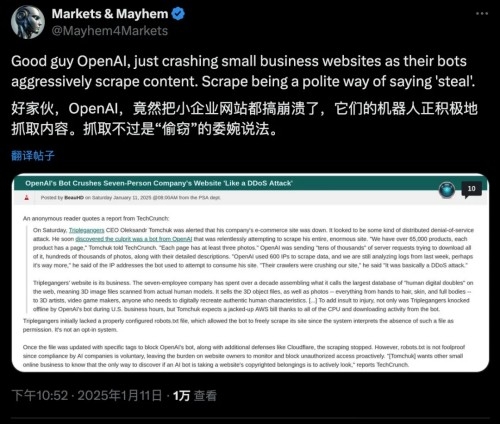

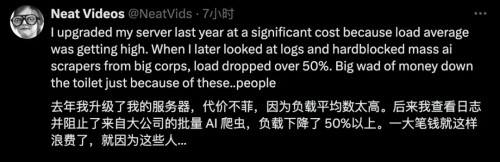

也有网友现身表示有类似的经历,自从阻止了大公司的批量AI爬虫,省了一大笔钱:

为什么小公司会成为目标?

OpenAI 的爬虫为什么会盯上 Triplegangers?答案在于数据的价值。

Triplegangers 的数据库是他们 10 多年努力的成果,号称全球最大的人类数字孪生数据库。这些数据包括高分辨率的 3D 图像,以及详细的标签化信息。对 AI 公司而言,这些 高质量、精细化的数据 无疑是训练大模型的“香饽饽”。尤其是在目前高质量数据稀缺的情况下,像 Triplegangers 这样的小型网站,常常成为爬虫的目标。

尽管 Triplegangers 的服务条款中明确写道 禁止未经许可抓取网站数据,但事实证明,这样的声明对 GPTBot 并没有约束力。

未配置 robots.txt,成为“爬虫漏洞”

更深层次的原因在于,Triplegangers 没有正确配置一个关键文件——robots.txt。

robots.txt 是一个标准协议,用来告诉爬虫哪些内容允许或禁止抓取。如果网站未设置 robots.txt,爬虫工具往往会默认认为可以抓取网站上的所有数据。

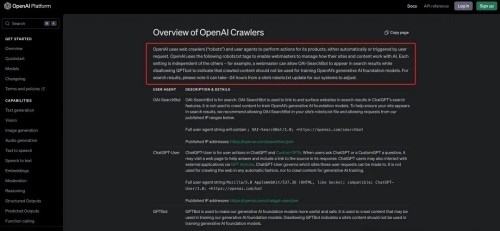

对于 OpenAI 的爬虫工具,阻止抓取的方式如下:

在 robots.txt 文件中添加禁止标签,明确声明 GPTBot 不得访问。

除了 GPTBot,OpenAI 还有其他爬虫工具,如 ChatGPT-User 和 OAI-SearchBot,它们也需要分别在 robots.txt 文件中设置相应的限制。

然而,即使立即添加了 robots.txt 文件,爬虫的抓取行为也不会立刻停止,因为 OpenAI 的系统可能需要 24 小时 才能识别和更新。

CEO老哥对此表示:

如果一个网站没有正确配置robots.txt文件,那么OpenAI和其它公司会认为他们可以随心所欲地抓取内容。

这不是一个可选的系统。

正因如此,也就有了Triplegangers在工作时间段网站被搞宕机,还搭上了高额的AWS费用。

截至美东时间的本周三,Triplegangers已经按照要求配置了正确的robots.txt文件。

以防万一,团队还设置了一个Cloudflare账户来阻止其它的AI爬虫,如Barkrowler和Bytespider。

虽然到了周四开工的时候,Triplegangers没有再出现宕机的情况,但CEO老哥还有个悬而未决的困惑——

不知道OpenAI都从网站中爬了些什么数据,也联系不上OpenAI……

而且令CEO老哥更加深表担忧的一点是:

如果不是GPTBot“贪婪”到让我们的网站宕机,我们可能不知道它一直在爬取我们的数据。

这个过程是有bug的,即便你们AI大公司说了可以配置robots.txt来防止爬虫,但你们把责任推到了我们身上。

最后,CEO老哥也呼吁众多在线企业,要想防止大公司未经允许爬虫,一定要主动、积极地去查找问题。

宕机并非个例,AI 爬虫屡惹争议

Triplegangers 的遭遇并非孤例。在此之前,Game UI Database 的团队也曾被 GPTBot 搞得焦头烂额。这家专门收录游戏用户界面截图的数据库网站,某天突然发现:

网站页面加载速度变慢三倍;

用户频繁遇到 502 错误;

服务器首页每秒被请求重载 200 次。

经检查发现,正是 OpenAI 的爬虫每秒发起两次请求,直接导致了网站的几乎瘫痪。

不止 OpenAI,其他 AI 公司也“疯狂爬取”

事实上,类似问题并不只存在于 OpenAI。以下是其他公司被曝光的案例:

数字产品工作室Planetary的创始人Joshua Gross曾表示过,他们给客户重新设计的网站上线后,流量激增,导致客户云成本翻倍。

经审计发现,大量流量来自抓取机器人,主要是Anthropic导致的无意义流量,大量请求都返回404错误。

针对这一现象,来自数字广告公司DoubleVerify的一份新研究显示,AI爬虫在2024 年导致“一般无效流量”(不是来自真实用户的流量)增加了86%。

AI公司疯狂爬虫背后的真相

为什么 AI 公司对网络数据如此“疯狂”?

核心原因是 高质量数据的匮乏。

一项研究指出,到 2032 年,全球用于 AI 模型训练的可用数据可能会枯竭。这一预期迫使 AI 公司加快数据收集速度,甚至开始直接购买未公开的内容。例如:

针对 YouTube、Instagram、TikTok 平台上的未发布视频,AI 公司开出了每分钟 1~4 美元 的高价。

根据视频质量和格式,价格还可能进一步提升。

对 AI 公司而言,只有掌握更多独家数据,才能在大模型竞争中占据先机。

小企业如何保护自己?

Triplegangers 的 CEO 最后呼吁在线企业采取主动措施,防止类似事件再次发生。以下是一些可行的防护策略:

正确配置 robots.txt 文件

确保明确声明哪些内容不允许爬虫访问。

部署防护工具

使用 Cloudflare 等流量监控工具,限制不正常的爬虫行为。

定期检查日志

分析服务器日志,识别异常流量和爬虫行为。

主动制定数据保护政策

在服务条款中清楚说明禁止未经许可抓取,并采取技术措施加以落实。

AI 爬虫的行为究竟是技术进步的必然,还是未经授权的数据“窃取”?在数据驱动的 AI 时代,这一问题不仅关乎技术发展,也涉及法律、伦理与商业规则的博弈。

你怎么看待这一现象?如何在技术与隐私之间找到平衡?欢迎在评论区留下你的观点。

一、纯原版ChatGPT、Claude

官网原生页面

真实Team会员账号

二、技术支持

✔️支持GPT-4o、o1、Canvas、Claude

✔️无需魔法

✔️个人独享

✔️24小时300次

✔️Open Ai官网ChatGPT Plus账号,20美元/月,算上其他成本,最低180元/月,我们直接99元/月,并且质保30天

三、支持所有GPTs

支持ChatGPT所有插件,可创建自己的ChatGPT插件,使用朋友分享的自定义插件。

当然也包含最强编程插件Code Copilot。